Przegląd

Najwyższa wydajność AI na Twoim biurku

NVIDIA® DGX Station™ należy do nowej klasy komputerów zaprojektowanych od podstaw do budowy i uruchamiania AI. Jest to pierwszy system zbudowany z wykorzystaniem superchipa NVIDIA GB300 Grace Blackwell Ultra Desktop, z możliwością rozbudowy do ogromnych 784 GB pamięci koherentnej — dostarczającą niespotykaną moc obliczeniową do rozwijania i uruchamiania dużych zadań treningowych i inferencyjnych AI bezpośrednio na Twoim biurku. Łącząc najnowocześniejsze możliwości systemowe ze stosem oprogramowania NVIDIA AI, stacje NVIDIA DGX są przeznaczone dla zespołów, które wymagają najlepszej platformy do rozwoju AI na biurku.

Cechy

Przełomy Technologiczne

NVIDIA Grace Blackwell Ultra Desktop Superchip

NVIDIA DGX Station wyposażona jest w procesor graficzny NVIDIA Blackwell Ultra, który zawiera rdzenie NVIDIA CUDA® najnowszej generacji oraz rdzenie Tensor piątej generacji, połączone z wysokowydajnym procesorem NVIDIA Grace za pomocą interfejsu NVIDIA® NVLink®-C2C, zapewniając najlepszą w swojej klasie komunikację systemową i wydajność.

Rdzenie Tensor piątej generacji

Stacje NVIDIA DGX są zasilane najnowszymi rdzeniami Tensor generacji Blackwell, umożliwiającymi obliczenia w formacie 4-bitowym zmiennoprzecinkowym (FP4). FP4 zwiększa wydajność i rozmiar modeli nowej generacji, które pamięć może obsługiwać, utrzymując jednocześnie wysoką dokładność.

NVIDIA ConnectX-8 SuperNIC

NVIDIA ConnectX®-8 SuperNIC™ jest zoptymalizowany do przyspieszania obciążeń obliczeniowych AI w skali hiperskalowej. Oferując łączność sieciową do 800 gigabitów na sekundę (Gb/s), NVIDIA ConnectX-8 SuperNIC dostarcza niezwykle szybkie i wydajne połączenia sieciowe, znacząco poprawiając wydajność systemu dla fabryk AI.

NVIDIA DGX OS

NVIDIA DGX OS implementuje stabilne, w pełni kwalifikowane systemy operacyjne do uruchamiania aplikacji AI, uczenia maszynowego i analityki na platformie NVIDIA DGX. Zawiera specyficzne dla systemu konfiguracje, sterowniki oraz narzędzia diagnostyczne i monitorujące. Łatwo skaluj w ramach wielu systemów NVIDIA DGX Station, NVIDIA DGX Cloud lub innej przyspieszonej infrastruktury centrów danych czy chmur.

Interkonekt NVIDIA NVLink-C2C

NVIDIA NVLink-C2C rozszerza wiodącą w branży technologię NVLink do interkonektu chip-to-chip między GPU a CPU, umożliwiając transfery danych o wysokiej przepustowości i koherentnych między procesorami i akceleratorami.

Duża koherentna pamięć dla AI

Modele AI nadal rosną w skali i złożoności. Trening i uruchamianie tych modeli w dużej koherentnej pamięci NVIDIA Grace Blackwell Ultra pozwala na efektywne trenowanie i uruchamianie modeli na ogromną skalę w jednej puli pamięci, dzięki interkonektowi superchip C2C, który omija wąskie gardła tradycyjnych systemów CPU i GPU.

Optymalizacja zasilania dostosowana do obciążenia

Stacje NVIDIA DGX korzystają z optymalizacji systemowych opartych na AI, które inteligentnie przesuwają moc w zależności od aktywnego obciążenia, nieustannie maksymalizując wydajność i efektywność.AI.

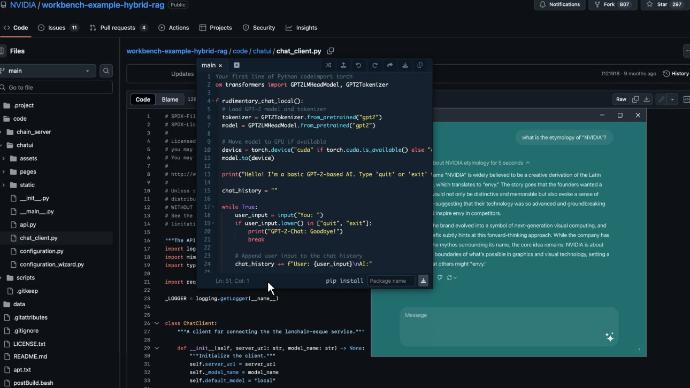

NVIDIA AI Software Stack

Kompleksowe rozwiązanie dla obciążeń AI, w tym dostrajania, wnioskowania i nauki o danych. Stos oprogramowania AI NVIDIA pozwala na lokalną pracę i łatwe wdrażanie w chmurze lub centrum danych, korzystając z tych samych narzędzi, bibliotek, frameworków oraz wstępnie wytrenowanych modeli od komputera stacjonarnego do chmury.

Obciążenia

Najwyższej klasy stacja robocza do AI i nauki o danych

Rozwój AI

Dzięki rozbudowanej bibliotece bibliotek zoptymalizowanych pod kątem NVIDIA CUDA, które przyspieszają trening głębokiego uczenia i uczenia maszynowego, w połączeniu z ogromną pamięcią i przepustowością superchipów stacji DGX, przyspieszona platforma obliczeniowa NVIDIA zapewnia najlepszą platformę do rozwoju AI w różnych branżach, od tworzenia systemów predykcyjnego utrzymania, poprzez analizę obrazów medycznych, aż po aplikacje przetwarzania języka naturalnego.

Nauka o danych

Dzięki oprogramowaniu AI NVIDIA, w tym bibliotekom oprogramowania open-source RAPIDS™, procesory graficzne znacznie obniżają koszty infrastruktury i zapewniają doskonałą wydajność dla kompleksowych procesów związanych z nauką o danych. Duża koherentna pula pamięci dostarczana przez superchip stacji DGX pozwala na bezpośrednie wczytywanie ogromnych jezior danych do pamięci, eliminując wąskie gardła w nauce o danych i przyspieszając przepustowość.

Wnioskowanie AI

Modele AI szybko rosną pod względem rozmiaru, złożoności i różnorodności—przekraczając granice możliwości. Stacje NVIDIA DGX przyspieszają wnioskowanie dla uruchamiania dużych modeli AI lokalnie na systemie, oferując niesamowitą prędkość w generowaniu tokenów dla dużych modeli językowych (LLM), analizie danych, tworzeniu treści, chatbotach AI i nie tylko.

Chmura osobista

Stacja NVIDIA DGX może służyć jako indywidualny komputer stacjonarny dla jednego użytkownika do uruchamiania zaawansowanych modeli AI z wykorzystaniem lokalnych danych lub jako centralny węzeł obliczeniowy dla wielu członków zespołu, którzy mogą dostosowywać i uruchamiać modele specyficzne dla IP na żądanie. Stacja DGX obsługuje technologię NVIDIA Multi-Instance GPU (MIG), umożliwiając podział na do siedmiu instancji do lokalnego rozwoju z wieloma użytkownikami, z każdą instancją w pełni izolowaną, z własną pamięcią o wysokiej przepustowości, pamięcią podręczną i rdzeniami obliczeniowymi – a także łatwym skalowaniem do większych wdrożeń MIG w chmurze i centrum danych. Daje to administratorom możliwość obsługi każdego obciążenia, od najmniejszych do największych, z gwarantowaną jakością usług (QoS) i rozszerza zasięg przyspieszonych zasobów obliczeniowych do każdego użytkownika.

Specyfikacje DGX Station*

| GPU NVIDIA | 1x NVIDIA Blackwell Ultra |

| CPU NVIDIA | 1x Grace-72 Core Neoverse V2 |

| Pamięć GPU | Do 288 GB HBM3e |

| Pamięć CPU | Do 496 GB LPDDR5X |

| NVLink-C2C | Do 900 GB/s |

| Sieć | Przepustowość szczytowa |

| Obsługiwane systemy operacyjne | NVIDIA DGX OS |

| MIG | 7 |

*Wstępne specyfikacje, mogą ulec zmianie.

Bądź na bieżąco

Zarejestruj się, aby otrzymać powiadomienia, gdy stacja DGX będzie już dostępna.