Przegląd

Wyższa wydajność i szybsza pamięć — ogromna przepustowość dla efektywności obliczeń

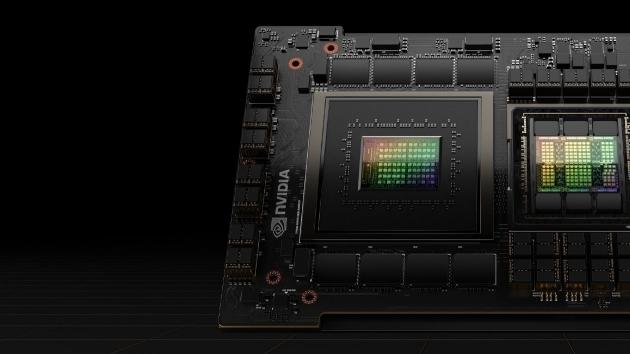

NVIDIA GH200 Grace Hopper™ Superchip to przełomowy procesor zaprojektowany od podstaw do wielkoskalowych zastosowań AI i HPC. Superchip zapewnia nawet do 10 razy wyższą wydajność dla aplikacji obsługujących terabajty danych, umożliwiając naukowcom i badaczom osiągnięcie bezprecedensowych rozwiązań dla najbardziej złożonych problemów świata.

Przyjrzyj się bliżej superchipowi

NVIDIA GH200 Grace Hopper Superchip

GH200 łączy architektury NVIDIA Grace™ i Hopper™ za pomocą NVIDIA NVLink™-C2C, zapewniając spójny model pamięci CPU+GPU do przyspieszonych zastosowań AI i HPC. Z interfejsem o przepustowości 900 GB/s superchip jest 7 razy szybszy niż PCIe Gen5. Z pamięcią GPU HBM3 i HBM3e, przyspiesza obliczenia oraz generatywną AI. GH200 obsługuje wszystkie stacki i platformy NVIDIA, w tym NVIDIA AI Enterprise, HPC SDK i Omniverse™.

Przeczytaj arkusz danych

Przeczytaj dokument Whitepaper

GH200 jest obecnie dostępny. Skontaktuj się z nami aby uzyskać więcej informacji.

NVIDIA GH200 NVL2

NVIDIA GH200 NVL2 w pełni łączy dwa superchipy GH200 za pomocą NVLink, oferując do 288 GB wysokowydajnej pamięci, 10 terabajtów na sekundę (TB/s) przepustowości pamięci oraz 1,2 TB szybkiej pamięci. Dostępny obecnie, GH200 NVL2 zapewnia do 3,5 razy większą pojemność pamięci GPU i 3 razy większą przepustowość niż GPU NVIDIA H100 Tensor Core w jednym serwerze do obciążeń wymagających intensywnych obliczeń i pamięci.

Wydajność

GH200 kontra dwusocketowy procesor klasy premium | Fizyczne obliczenia: MILC Apex Medium

Obliczenia naukowe

Łącząc oparte na Arm® architektury CPU Grace i GPU Hopper za pomocą NVLink-C2C, superchipy NVIDIA GH200 przyspieszają badania naukowe i odkrycia w superkomputerach na całym świecie. W połączeniu, superkomputery wykorzystujące superchipy NVIDIA Grace Hopper dostarczają 200 eksaflopsów, czyli 200 kwintylionów obliczeń na sekundę, zapewniając energooszczędną moc przetwarzania AI.

Wyniki NDS-DS uruchamiające Apache Spark z akceleratorem NVIDIA RAPIDS™

na 16-nodowym systemie GH200 przy użyciu SF10 versus 16-nodowe procesory

klasy premium.

Przetwarzanie danych

Najnowsze osiągnięcia w zakresie przepustowości pamięci masowej i sieciowej, wraz z końcem prawa Moore’a, przesunęły wąskie gardła analizy i zapytań na CPU. Dzięki GH200, CPU i GPU dzielą wspólną tabelę stron na poziomie procesu, umożliwiając wszystkim wątkom CPU i GPU dostęp do całej przydzielonej pamięci systemowej, która może znajdować się na fizycznej pamięci CPU lub GPU. GH200 usuwa konieczność kopiowania pamięci między CPU a GPU, co przyspiesza przetwarzanie danych nawet do 36 razy.

Face | batch = 1 024 | wyjściowe wektory = 85 mln o rozmiarze 768. | Wyszukiwanie wektorów: batch = 10 000 | zapytania o wektory = 10 000 na 85 mln wektorów.

Generowanie wspomagane wyszukiwaniem

(Retrieval-Augmented Generation)

Najnowsze osiągnięcia w zakresie przepustowości pamięci masowej i sieciowej, wraz z końcem prawa Moore’a, przesunęły wąskie gardła analizy i zapytań na CPU. Dzięki GH200, CPU i GPU dzielą wspólną tabelę stron na poziomie procesu, umożliwiając wszystkim wątkom CPU i GPU dostęp do całej przydzielonej pamięci systemowej, która może znajdować się na fizycznej pamięci CPU lub GPU. GH200 usuwa konieczność kopiowania pamięci między CPU a GPU, co przyspiesza przetwarzanie danych nawet do 36 razy.

Graph neural network, based on full GraphSAGE model measurements comparing PCIe H100 versus GH200.

Graph Neural Network

Graph neural networks (GNNs) are used in a wide range of applications, such as social network analysis, drug discovery, fraud detection, and molecular chemistry. GH200 takes advantage of the up to 624GB of combined CPU and GPU fast memory, 4 petaFLOPS of H200 GPU, and the 900 GB/s NVLink-C2C to speed up GNN training by up to 8X compared to the H100 PCIe GPU.

Odkryj Laboratoria LaunchPad z GH200

Przyspiesz obliczenia i AI z Grace Hopper

W tej prezentacji doświadczysz bezproblemowej integracji superchipu NVIDIA GH200 Grace Hopper z platformami programistycznymi NVIDIA. Zawiera interaktywne demo, przykłady zastosowań w rzeczywistych scenariuszach oraz studia przypadków, w tym modele LLM.

Zbadaj projekt referencyjny Grace Hopper dla współczesnych obciążeń Centrum Danych

NVIDIA MGX z GH200 do szkolenia AI, inferencji, 5G i HPC

NVIDIA MGX™ to modułowy projekt referencyjny, który może przyspieszyć różnorodne zadania w przedsiębiorstwach. Integrując zaawansowane możliwości superchipa GH200 z jednostkami BlueField®-3 DPU, wejściami/wyjściami zdefiniowanymi przez OEM oraz czwartą generacją NVLink, MGX oferuje rozwiązania dostosowane do współczesnych centrów danych.

Gotowy, aby zacząć?

Porozmawiaj z ekspertem produktowym NVIDIA, aby dowiedzieć się więcej o NVIDIA Grace Hopper.