Przegląd

Czym jest MLPerf?

Benchmarki MLPerf™ — opracowane przez MLCommons, konsorcjum liderów AI z akademii, laboratoriów badawczych i przemysłu — mają na celu dostarczenie bezstronnych ocen wydajności treningu i wnioskowania dla sprzętu, oprogramowania i usług. Wszystkie testy są przeprowadzane w określonych warunkach. Aby pozostać na czołowej pozycji w branżowych trendach, MLPerf nieustannie ewoluuje, organizując nowe testy w regularnych odstępach czasu i dodając nowe obciążenia, które reprezentują stan wiedzy w AI.

Wnętrze benchmarków MLPerf

MLPerf Inference v5.0 mierzy wydajność wnioskowania na 11 różnych benchmarkach, w tym kilku dużych modelach językowych (LLM), generatywnej AI do przetwarzania tekstu na obraz, rekomendacji, widzeniu komputerowym, segmentacji obrazów biomedycznych oraz sieciach neuronowych grafowych (GNN).

MLPerf Training v4.1 mierzy czas potrzebny do treningu na siedmiu różnych benchmarkach, w tym wstępnym treningu LLM, dostrajaniu LLM, generowaniu obrazów z tekstu, GNN, widzeniu komputerowym, rekomendacjach oraz przetwarzaniu języka naturalnego.

MLPerf HPC v3.0 mierzy wydajność treningu w czterech różnych zastosowaniach obliczeń naukowych, w tym identyfikacji rzek atmosferycznych klimatu, predykcji parametrów kosmologicznych, modelowaniu cząsteczek kwantowych oraz przewidywaniu struktury białek.

Duże modele językowe

Algorytmy głębokiego uczenia trenowane na dużych zbiorach danych, które potrafią rozpoznawać, podsumowywać, tłumaczyć, przewidywać i generować treści dla różnych przypadków użycia.

MLPerf Training wykorzystuje generatywny model językowy GPT-3 z 175 miliardami parametrów i długością sekwencji 2,048 na zbiorze danych C4 dla obciążenia wstępnego treningu LLM. Dla testu dostrajania LLM używany jest model Llama 2 70B w zbiorze danych GovReport z długościami sekwencji 8,192. MLPerf Inference korzysta z modelu Llama 3.1 405B z następującymi zbiorami danych: LongBench, RULER oraz podsumowanie GovReport; model Llama 2 70B z zbiorem danych OpenORCA; model Mixtral 8x7B z zbiorami danych OpenORCA, GSM8K i MBXP; oraz model GPT-J z zbiorem danych CNN-DailyMail.

Przetwarzanie tekstu na obraz

Generuje obrazy na podstawie wskazówek tekstowych.

MLPerf Training wykorzystuje model tekst-na-obraz Stable Diffusion v2, wytrenowany na zbiorze danych LAION-400M-wyfiltered.

MLPerf Inference korzysta z modelu tekst-na-obraz Stable Diffusion XL (SDXL) z podzbiorem 5,000 wskazówek z zbioru danych coco-val-2014.

Rekomendacje

Dostarcza spersonalizowane wyniki w usługach skierowanych do użytkowników, takich jak media społecznościowe czy strony internetowe e-commerce, rozumiejąc interakcje między użytkownikami a przedmiotami usługowymi, takimi jak produkty czy reklamy.

MLPerf Training i Inference wykorzystują model rekomendacji głębokiego uczenia v2 (DLRMv2), który stosuje warstwę krzyżową DCNv2 oraz zbiór danych z wieloma gorącymi wartościami, stworzony na podstawie zbioru danych Criteo.

Wykrywanie obiektów (lekka wersja)

Znajduje przypadki obiektów rzeczywistych, takich jak twarze, rowery i budynki w obrazach lub filmach i określa prostokątny obszar wokół każdego z nich.

MLPerf Training wykorzystuje Single-Shot Detector (SSD) z architekturą ResNeXt50 na podzbiorze zbioru danych Google OpenImages.

Sieci neuronowe grafowe

Wykorzystuje sieci neuronowe zaprojektowane do pracy z danymi ustrukturyzowanymi w postaci grafów.

MLPerf Training i Inference wykorzystują R-GAT z Illinois Graph Benchmark (IGB) - zbiór danych heterogenicznych.

Klasyfikacja obrazów

Przypisuje etykietę z ustalonego zestawu kategorii do obrazu wejściowego, tj. stosuje się do problemów związanych z widzeniem komputerowym.

MLPerf Training i Inference wykorzystują ResNet v1.5 z zbiorem danych ImageNet.

Przetwarzanie języka naturalnego (NLP)

Rozumie tekst, wykorzystując relacje między różnymi słowami w bloku tekstu. Umożliwia zadawanie pytań, parafrazowanie zdań oraz wiele innych zastosowań związanych z językiem.

MLPerf Training wykorzystuje Bidirectional Encoder Representations From Transformers (BERT) na zbiorze danych Wikipedia z dnia 01.01.2020.

Segmentacja obrazów biomedycznych

Wykonuje segmentację wolumetryczną gęstych obrazów 3D do zastosowań medycznych.

MLPerf Training i Inference wykorzystują 3D U-Net z zbiorem danych KiTS19.

Identyfikacja rzek atmosferycznych klimatu

Identifikuje huragany i rzeki atmosferyczne w danych symulacyjnych klimatu.

Wykorzystuje model DeepCAM z zestawem danych symulacji CAM5 + TECA.

Predykcja parametrów kosmologicznych

Rozwiązuje problem regresji obrazów 3D na podstawie danych kosmologicznych.

Wykorzystuje model CosmoFlow z zestawem danych symulacji N-body CosmoFlow.

Modelowanie molekularne kwantowe

Przewiduje energie lub konfiguracje molekularne.

Wykorzystuje model DimeNet++ z zestawem danych Open Catalyst 2020 (OC20).

Przewidywanie struktury białek

Przewiduje trójwymiarową strukturę białka na podstawie jednostkowej łączności aminokwasów.

Wykorzystuje model OpenFold wytrenowany na zbiorze danych OpenProteinSet.

Wyniki benchmarków NVIDIA MLPerf

Technologia stojąca za wynikami

Złożoność AI wymaga ścisłej integracji wszystkich aspektów platformy. Jak pokazano w benchmarkach MLPerf, platforma AI NVIDIA zapewnia wydajność klasy lidera dzięki najnowocześniejszym procesorom graficznym, potężnym i skalowalnym technologiom interkonektów oraz nowatorskiemu oprogramowaniu — kompleksowe rozwiązanie, które można wdrożyć w centrum danych, w chmurze lub na brzegu sieci z niesamowitymi wynikami.

Zoptymalizowane oprogramowanie, które przyspiesza procesy AI

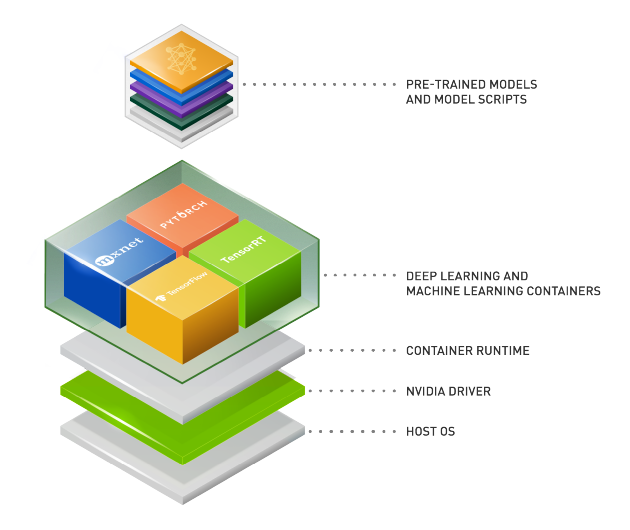

NGC™ katalog jest niezbędnym składnikiem platformy NVIDIA oraz wyników treningu i wnioskowania MLPerf, stanowiąc centrum oprogramowania zoptymalizowanego pod kątem GPU dla AI, HPC i analizy danych, które upraszcza i przyspiesza procesy robocze end-to-end. Z ponad 150 kontenerami klasy przedsiębiorstwa — w tym obciążeniami dla generatywnej AI, AI konwersacyjnej i systemów rekomendacyjnych; setkami modeli AI; oraz specyficznymi dla branży zestawami SDK, które można wdrażać na miejscu, w chmurze lub na brzegu — NGC umożliwia naukowcom danych, badaczom i deweloperom budowanie rozwiązań klasy światowej, gromadzenie wglądów i dostarczanie wartości biznesowej szybciej niż kiedykolwiek.

Infrastruktura AI klasy lidera

Osiągnięcie wyników na światowym poziomie w zakresie treningu i wnioskowania wymaga infrastruktury stworzony specjalnie dla najbardziej złożonych wyzwań AI na świecie. Platforma AI NVIDIA dostarczyła wiodącą wydajność zasilaną przez platformę NVIDIA Blackwell, platformę Hopper, NVLink, NVSwitch™ oraz Quantum InfiniBand. Te technologie są sercem fabryk AI napędzanych przez platformę centrum danych NVIDIA, która stanowi silnik naszych wyników benchmarkowych.

Dodatkowo systemy NVIDIA DGX™ oferują skalowalność, szybkie wdrożenie i niesamowitą moc obliczeniową, co umożliwia każdemu przedsiębiorstwu budowanie infrastruktury AI klasy lidera.

Odblokowywanie generatywnej AI na brzegu z przełomową wydajnością

NVIDIA Jetson Orin oferuje niezrównaną moc obliczeniową AI, dużą zintegrowaną pamięć oraz kompleksowe stosy oprogramowania, zapewniając doskonałą efektywność energetyczną dla najnowszych aplikacji generatywnej AI. Może szybko realizować wnioskowanie dla dowolnych modeli generatywnych AI opartych na architekturze transformatora, oferując wyjątkową wydajność na brzegu w MLPerf.

Gotowy, aby zacząć?

Porozmawiaj z ekspertem produktowym NVIDIA, aby dowiedzieć się więcej o wydajności treningu i wnioskowania w centrum danych.